Summer Workshop by #rhizomatiksresearch に参加しました(1日目編)

ライゾマの高校生限定ワークショップに参加してきました!わーい

経緯

中高生向けの夏休みワークショップをライゾマスタジオにて @motoi_ishibashi 氏とやりたいねと話しているのですが3日間やるとしたらいつ頃が都合が良いのでしょうか。ロボットアーム、ドローン、モーキャプ、3Dスキャン、レーザー、ムービングライト、画像解析などなど。。

— daitomanabe (@daitomanabe) 2015, 5月 31

1日目

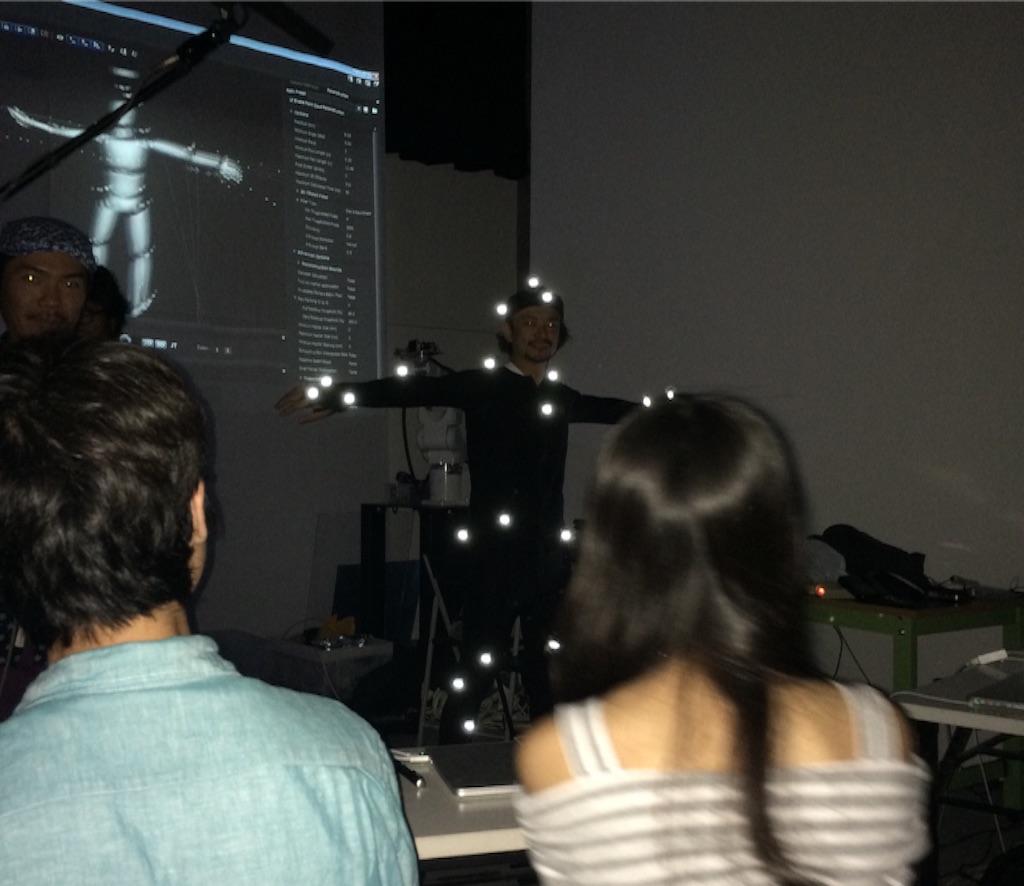

<INPUT>赤外線関連とモーキャプ by花井さん、登本さん、石橋さん

赤外線(Infrared;IR)→波長の長い電磁波(波),不可視光 波長は700nm~1mm

ライゾマでよく使うのは800~900nmの赤外線

普通のデジカメでは、赤外線もイメージセンサで捉えることができるのを、間にIRカットフィルタを挟むことでなくしてる。赤外線カメラは逆に、可視光と波長が長い光をカットするバンドパスフィルタを挟むことで欲しい波長の光だけを抽出することができる。

位置データを取るためにこれと合わせて使うのが再帰性反射材(道路標識や工事現場のおじさんが着てるやつ)。再帰性反射材は素材の細かいところが球体またはキューブ状になっていて、きた光を同じ方向に返すようにできている。赤外線投光機をカメラ付近に設置して投光すると、再帰性反射材から返ってきた反射光をもとにしてその物体の位置がわかる。何台ものカメラで位置を取れば立体的に場所をとることもできる。

3M|技術情報:反射の種類/反射の仕組み|反射材・交通安全関連製品について|反射材・交通安全関連製品|セーフティ・セキュリティ関連|製品とサービス

赤外線を使う理由→人の目では見えないからぱっと見わからず制御できるから

(以下1日目午後)

ハードウェア|OptiTrack【フルボディモーションキャプチャーシステム】

調べてみて今「値段神高いな」っていう顔してる

Perfumeライブの凄すぎるプロジェクション技術を推考(動画あり)(答え合わせ追記しました) : ギズモード・ジャパン

Watch 3D Projections Transform Dancers into Constellations | The Creators Project

<INPUT>ネットワーク by真鍋さん

ネットワーク→複数のコンピュータを接続する技術。大きな作品を作るとき、映像・音・動作の処理を全部同じPCでするとキツイから複数台使うときに便利。

IPアドレス:PCの住所

ポート番号:マンションの部屋番号

MAXで実践 真鍋さんのパソコンと我々のパソコンでメッセージを送り合う

今回のワークショップ中にレーザーやLEDを制御するときは、各参加者のPCからEthernet通して(?)送ってた。

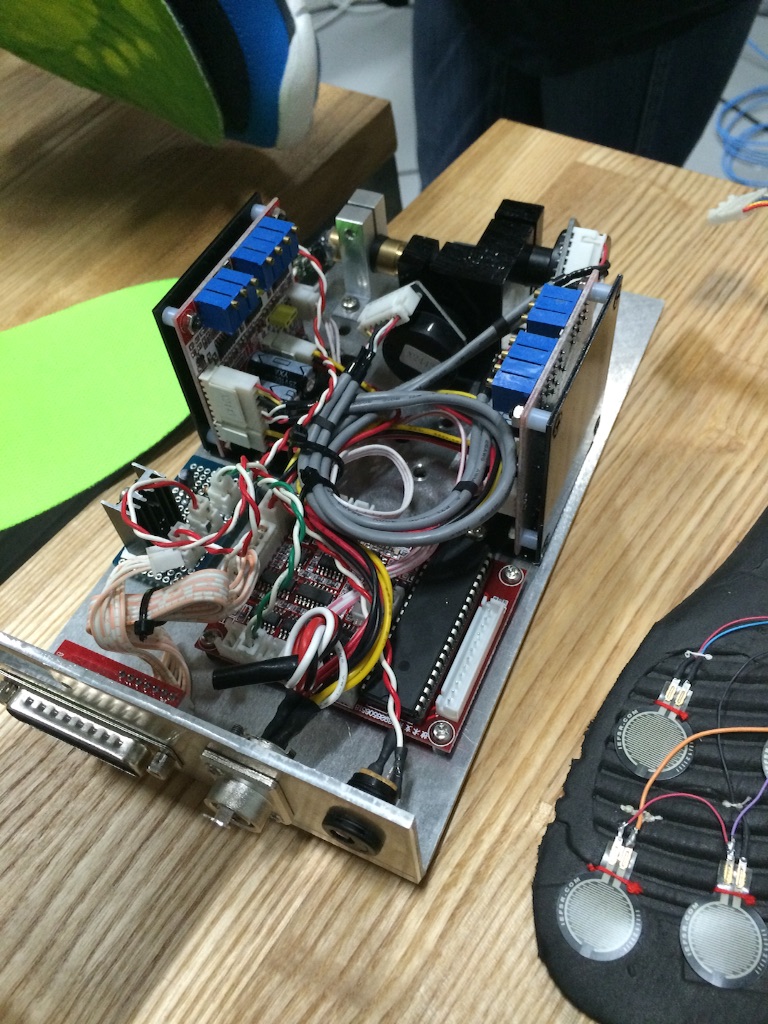

<INPUT>センサー by柳澤さん

<OUTPUT>LED, レーザー, 筋電 by真鍋さん

*レーザーモジュール

<INPUT,処理>モーションキャプチャ(処理ネタ) by石橋さん

上記

<INPUT,処理>画像認識 by登本さん

画像に限らなければ機械学習の話。

画像の中に何が写っているかを機械が判定するとき、機械は特定のモノを"学習"して類似度を測定する仕組みになっている。人は何が写っているか瞬時に反応できるけどコンピュータだと難しい。ちょっと前のgggでやってたグラフィックの死角展がそれでしたよね…行きたくていけなかったやつ。機械学習興味あるガールで研究したいかもしれないガールなのですごい興味深かった。詳しく知りたいのでもうちょい調べる。

コンピュータで画像・動画を解析するときは、見たいデータを取るために特定のフィルタ(laplacian pyramid,特徴点抽出,速度など)をかけて処理する。前akeさんからお聞きした、画像から脈拍はかるやつ思い出した。

【Webカメラで脈拍を非接触リアルタイム・センシング】Version 0.48

<INPUT>電波の取得、可視化

<INPUT>三次元データ by花井さん

depthデータが取れればマーカーがなくてもトラッキングできる。それをOSCで送ってごにょれる。

取る方法は今手軽に使えるのだとkinectが言わずもなが有名なのですが

- kinect : structured lightっていう方法(赤外線パターンを投光して赤外線カメラで撮影することでdepthをとる)

- kinectV2 : 赤外線を投光して、反射して帰ってくるその速度から距離を測定

- BunbleBee : カメラが2個ついてて人の目とおなじ構成みたいな? 株式会社ビュープラス

<OUTPUT>大物 by石橋さん、原田さん

*ロボットアーム

アームは大きく分けて6軸と4軸があるけど、見栄えとかの問題などでライゾマはEPSONの6軸アームを使っている。買うには法律で決められた安全講習を受けて資格を得る必要がある。基本的には各モーターの位置を入力してその値を記憶し(ティーチング)、再生するという仕組み。会社によって開発環境も言語も違う。高級車一台買えるくらいの値段。

*ドローン

前記のようにモーキャプして位置を得る。いたい場所と現実のズレから計算して自動的に修正するようにプログラムしてる。紅白では場所をMayaでCGデータを作って書き出してたっぽい。

*ステッピングモータ、ウィンチ

YASKAWA × Rhizomatiks × ELEVENPLAY - YouTube

これで上からつられてるやつ。

モータってDC/ACとサーボとステッピング(プリンターの中に入ってるやつ、高精度)の三種類があるっぽい(差は理解しておらず)。実演してくださったときコンピュータがしくって左右両方のモータが回った結果片方の糸が切れてプラーン事件が発生しました。

本当はシェアのしやすさの問題上記事を一個にまとめたかったのですがモリモリになっちゃったのでここでひとまずアップ。あとで調べたこと追記していくスタイルにしていこう。感想などは次の記事で!